Les économistes souhaiteraient faire de l’économie une science exacte au même titre que les sciences physiques. Ils tentent pour cela d’établir des relations mathématiques entre des grandeurs mesurables. Malheureusement, le choix de ces grandeurs est très pauvre. Il semble se limiter à deux. L’une est le temps qui est clairement défini. L’autre est la monnaie dont l’unité, autrefois liée à l’étalon or, est aujourd’hui plutôt mal définie, et semble fluctuer de façon incontrôlable.

Nous avons vu qu’une société humaine est une structure dissipative. Elle est modélisable comme un réseau d’agents échangeant de l’information. D’un point de vue strictement économique, l’information échangée est la monnaie. Il semble qu’on ait là de quoi jeter les bases d’une véritable science économique. Peut-on appliquer les résultats d’Ulanowicz à l’économie?.

On se heurte d’emblée à un problème fondamental lié à la notion de structure dissipative. Par définition, celles-ci sont dans un état stationnaire, c’est-à-dire qu’elles n’évoluent pas. Malheureusement on s’intéresse justement à leur évolution. Comment faire? En dynamique des fluides, on suppose que l’évolution d’un cyclone est suffisamment lente pour qu’on puisse encore définir la température et la pression du gaz en chaque point. C’est ce qu’on appelle l’équilibre thermodynamique local. Lorsqu’on mesure l’état d’un écosystème, on suppose implicitement que cet état ne varie pas sensiblement durant le temps des mesures. L’hypothèse apparait valable compte tenu de la précision des mesures. Qu’en est-il de l’économie?

Les économistes résolvent généralement le problème en définissant l’état d’une économie sur l’échelle d’une année. Ce choix naturel permet de moyenner les fluctuations saisonnières (mais peut poser des problèmes dans le cas très fluctuant de l’économie financière). Quelle serait donc l’équivalent du paramètre d’ordre α d’Ulanowicz? Si l’on définit l’information comme étant donnée par la monnaie, alors l’information mémorisée est le capital. Cette information est en général mémorisée sur un compte bancaire. Normalisée au maximum égal à 1, c’est la fraction α du revenu annuel qui est capitalisée en vue de rapporter l’année suivante.

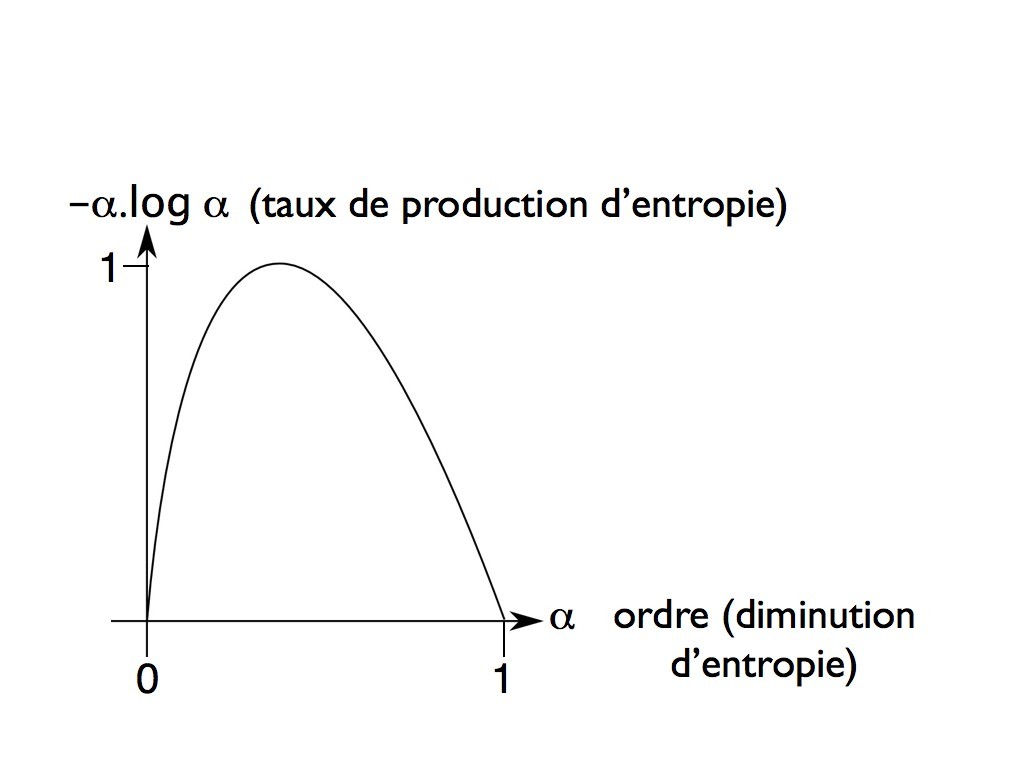

La quantité α est une variable aléatoire dont la réalisation n’est connue qu’à la fin de l’année i. L’expression d’Ulanowicz montre que α(i) peut aussi être considéré comme un estimateur bayésien (1) de la probabilité de profit pour l’année i+1. En ce sens, α(i) apporte pour l’année suivante une information α(i+1) qui vaut en moyenne α(i+1) = -α(i).log α(i). La quantité α(i+1) est ce qu’on appelle le revenu du capital. Les économistes la mettent sous la forme α(i+1) = r.α(i) où r est le rendement du capital. On voit que l’expression d’Ulanowicz implique un rendement du capital de la forme r = -log α. Cela peut paraître surprenant car il est infini à l’origine. Nous allons voir que c’est effectivement le cas.

Si l’on réinvestit chaque année le revenu du capital, on a ce qu’on appelle un revenu d’intétêts composés caractéristique des processus autocatalytiques. Une fois réinvesti le revenu du capital devient un nouveau capital α(i+1) = r.α(i), terme d’une progression géométrique de raison r. Il s’agit bien d’une cascade d’événements typique des processus d’auto-organisation. On sait que ces cascades sont déclenchées par des fluctuations aléatoires, ici des pertes ou des gains accidentels en moyenne nuls. Un gain de moyenne nulle peut être considéré comme un revenu accidentel sans capital. Son rendement est bien infini. Lorsque ce gain est investi, il peut engendrer une cascade plus ou moins importante d’événements capables de créer des fortunes. C’est la base du système capitaliste, souvent qualifié de « rêve américain », dans lequel n’importe qui est sensé pouvoir devenir riche.

L’expression d’Ulanowicz implique qu’il existe une valeur critique α = 1/e (37%) pour laquelle la raison r = -log α de la progression est égale à l’unité. Le revenu du capital compense alors tout juste les dépenses et maintient le capital constant. Lorsque α < 1/e, la raison r de la progression est supérieure à l’unité, de sorte que le capital croit chaque année. Dans le cas d’un pays, on parle de croissance économique. Lorsque α > 1/e, la raison r de la progression devient inférieure à l’unité et le capital décroit. Lorsqu’il y a eu création monétaire, c’est-à-dire que le capital a été emprunté à une banque, alors il ne peut plus être remboursé et c’est la faillite, d’où la terreur des économistes à l’idée d’une décroissance économique.

Tout système économique, nation ou entreprise, cherche à maximiser le revenu de son capital de façon à faire croître ce dernier. On voit qu’il y a une limite au delà de laquelle le capital ne croit plus et même décroit, c’est le point critique caractérisé par le nombre sans dimension 1/e. Il semblerait que l’on puisse généraliser ce résultat à toute structure dissipative (2). Celle-ci va s’adapter à son environnement de façon à maximiser l’information reçue jusqu’au moment ou l’information qu’elle mémorise ne croit plus et même décroit. Elle a alors atteint le point critique. Elle mémorise alors autant d’information qu’elle en efface. Cela implique que le point critique est aussi un point de dissipation maximale d’énergie. On sait qu’une structure dissipative oscille constamment autour du point critique en quête du maximum (billet 21).

(1) Un estimateur bayésien (ou inférence bayésienne) estime la probabilité d’un événement à partir de celles d’événements précédents.

(2) Considérée comme un réseau d’agents échangeant de l’information.